- Untuk mengetahui apa itu Ceph Cluster.

- Untuk mengetahui bagaimana konfigurasi pada ceph cluster.

Konsep Dasar

Admin-node berfungsi untuk menginstalasi ceph ke node1, node2, node3, dan client. Karena, jika kita instalasi satu persatu keyringnya akan berbeda dan ceph sendiri tidak akan saling sinkronisasi. Untuk OSD, menggunakan node1, node2 dan node3 dengan menggunakan harddisk tambahan ke masing-masing node. MON dan MDS hanya perlu diinstal pada node1. Untuk kliennya sendiri harus di upgrade kernelnya, karena ceph tidak support menggunakan kernel 2.x.

Software Ceph berjalan pada perangkat keras komoditas .Sistem ini dirancang untuk menjadi penyembuhan diri dan self-managing dan berusaha untuk mengurangi beban administrator dan terjadinya overhead.

Topologi

Table Address

Admin=172.16.11.212

Node1=172.16.11.213

Node2=172.16.11.214

Node3=172.16.11.215

Client=172.16.11.216

Konfigurasi

- Edit file hosts pada setiap node dengan sintaks "vi /etc.hosts"

- Disable selinux dengan perintah "vi /etc/selinux/config"

- Matikan firewall dan buat setenforce menjadi 0

- pada "admin" kita buat ssh-copy-id yang berfungsi agar ketika kita ssh ke node lain, maka tidak diperlukan lagi password untuk login dengan menginstall openssh-client

- Lalu jalankan perintah "ssh-keygen"

- jalankan perintah ssh-copy-id yang fungsinya untuk menyimpan password dari server yang kita remote dengan perintah "ssh-copy-id -i -/.ssh/id_rsa.pub node1(node2-node3-client)

- Install wget untuk mendownload repository ceph dengan perintah "yum install -y wget"

- Jika sudah, kita harus menginstall repository epel dan ceph. Install terlebih dahulu wget lalu download paket epel dan ceph dengan perintah "wget -c http://ceph.com/rpm-firefly/el6/noarch/ceph-release-1-0.el6.noarch.rpm http://dl.fedoraproject.org/pub/epel/6/x86_64/epel-release-6-8.noarch.rpm"

pariwara : toko bunga karawang

- Sekarang install paket menggunakan perintah rpm -ivh

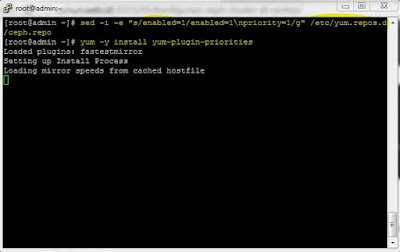

- setelah itu tambahkan priority=1 pada admin-node sebelum kita menginstall ceph dan ceph-deploy dengan perintah"sed -i -e “s/enabled=1/enabled=1\npriority=1/g” /etc/yum.repos.d/ceph.repo" dan langsung install yum plugin

- Selanjutnya install ceph ceph-deploy nya

- buat direktory dengan nama ceph-cluster pada /etc untuk penyimpanan konfigurasi ceph. Jika sudah, masuk ke directory tersebut dengan perintah cd dan buatlah ceph MON ke node 1 dengan perintah"ceph-deploy new node_1"

- sekarang kita akan menginstal ceph ke node1 sampai node3 dengan perintah "ceph-deploy install admin-node node_1 node_2 node_3"

- Lalu buat admin-keyring dengan perintah "ceph-deploy mon create-initial"

- Memformat harddisk dengan perintah"parted -s /dev/sdb mklabel gpt

" "parted -s /dev/sdb mkpart primary xfs 0% 100%" "

mkfs.xfs /dev/sdb1 -f"

- Kemudian, buat direktori /ceph-osd untuk mountingan partisi yang sudah diformat dan mounting partisi tersebut denagn perintah "mount -t xfs /dev/sdb1 /ceph-osd/"

- tambahkan script pada file "vi /etc/fstab" dengan script"/dev/sdb1 /ceph-osd xfs defaults 0 0"

- buat ceph object atau OSD pada admin dengan perintah"ceph-deploy osd prepare node_1:/ceph-osd node_2:/ceph-osd node_3:/ceph-osd"

- Sekarang aktifkan ceph object dengan perintah"ceph-deploy osd activate node_1:/ceph-osd node_2:/ceph-osd node_3:/ceph-osd"

- copykan file konfigurasi ceph dari admin ke node_1 sampai 3 dengan perintah "ceph-deploy admin admin-node node_1 node_2 node_3"

- berikan hak akses read pada file ceph.client.admin.keyring dengan menggunakan perintah "chmod +r /etc/ceph-cluster/ceph.client.admin.keyring"

- Lalu buat metadata server ke node 1 dengan perintah "ceph-deploy mds create node1"

- cek status kesehatan ceph yang berfungsi sebagai active + clean dengan menjalankan perintah"ceph health"

- Cek juga quorum status dengan perintah "ceph quorum_status –format=json-pretty"

- Beralih ke client, install xen agar ceph lebih stabil karena kita menggunakan virtual

- update kernel dengan perintah "yum update kernel -y"

- Jika sudah, pada admin install ceph ke client dengan perintah "ceph-deploy install client" dan "ceph-deploy admin client"

- buat disk baru dengan menggunakan rbd dan membuat mapping dari disk yang sudah dibuat dengan perintah "rbd create disk1 –size 5012" "rbd map disk1" "rbd showmapped"

- Berikutnya adalah memformat disk yang sudah dimapping

- Setelah diformat kita mountingkan partisi tersebut

- buat pool pada ceph OSD dan buat secret file dengan menyalin key dari file ceph.client.admin.keyring. Kemudian salin key tersebut dan buat file baru untuk menyimpan key tersebut

- Selanjutnya buat directory untuk memounting driver ceph dengan perintah"mkdir /mnt/cephfs" "mount -t ceph 192.168.100.213:6789:/ /mnt/cephfs -o name=admin,secretfile=/etc/ceph/admin.secret"

- berikutnya menginstal paket ceph-fuse

- Selanjutnya jika proses instalasi sudah selesai buat directory dan mounting dengan filesystem dengan perintah "mkdir mycephfs" "ceph-fuse -m 192.168.100.213:6789 mycephfs/"

0 komentar:

Posting Komentar